Die Wichtigkeit von Big Data Testing für das Data Quality Management

Was ist Big Data?

Um Big Data Testing zu verstehen, ist es wichtig, Big Data zu verstehen. Big Data ist eine große Menge an Daten mit einem großen Volumen und wird heutzutage als das größte Kapital von Unternehmen angesehen. Diese Daten sind das Herzstück, das es ermöglicht,;

- Entwickeln Sie neue Ideen,

- Verbessern Sie die Geschäftsberichterstattung,

- Verbessern Sie die Entscheidungsfindung,

- Automatisieren Sie komplexe Produkte für maschinelles Lernen und Data Vision.

Eine Studie von Deloitte hat ergeben, dass 62% der Unternehmen Big Data nutzen, um wirtschaftliche Entscheidungen zu treffen. Die Nutzer stellen ihre Daten regelmäßig in öffentlichen Foren zur Verfügung, z.B. über Google-Dienste, Facebook, Apple Cloud und andere Plattformen. Es ist daher nicht überraschend, dass Facebook jeden Tag 4 PETBYTE an Daten generiert, und das ist der größte Teil der Daten, nach denen Unternehmen suchen. Unternehmen benötigen Daten, um aufschlussreiche Analysen und bessere Entscheidungen zu treffen.

Am einfachsten lässt sich Big Data verstehen, wenn man seine wörtliche Bedeutung nimmt - Big Data. Eine große Menge an Daten, die zur Gewinnung nützlicher Erkenntnisse genutzt werden kann. Facebook Inc. hat etwa 2 Milliarden Nutzer, die aktiv ihre Daten veröffentlichen. Auch wenn ein Benutzer nichts hochlädt, überträgt er Datenpakete auf den Server und teilt seinen Standort mit. All diese Daten werden gesammelt und strukturiert, um sie zu nutzen. Deshalb ist Facebook ein Riesenerfolg.

Die 3 Formen der gesammelten Daten sind;

Strukturiert,

Unstrukturiert, und/oder

Halbstrukturiert.

Wie der Name schon sagt, unterscheiden sie sich durch die Art und Weise, wie Daten in Informationen umgewandelt werden können. Betrachten wir sie genauer.

Die erste Variante, strukturierte Daten, ist organisiert und der Abruf ist einfach. Einfacher Abruf bedeutet, dass einfache Datenbankabfragen zum Abrufen der Daten verwendet werden können. Diese Daten liegen in Form von Datenbanken auf Unternehmensebene, Datenbanken, Lagerhäusern und CRM-Systemen vor.

Unstrukturierte Daten sind Daten, die nicht in Tabellenform vorliegen, sondern in Form von Dateien, Informationspaketen oder Datenströmen. Die häufigsten Beispiele sind GPS-Ortungsströme, Sprachnachrichten und/oder analoge Daten.

Halbstrukturierte Daten schließlich sind Daten, die nicht durch einfache Abfragen abrufbar sind, die aber nach einer gewissen Verarbeitung das Potenzial dazu haben. Sie enthalten oft Metadaten oder Tags wie CSV-, XML- oder JavaScript Object Notation-Dateien.

Was ist Big Data Testing?

Bigdata-Anwendungen müssen in einem größeren Maßstab getestet werden als alle anderen. Dieses Verfahren wird als Bigdata Testing bezeichnet. Wenn große Datensätze vorliegen, die sich nicht mit herkömmlichen und einfachen Berechnungen erfassen lassen, kommt diese Methode gerade recht. Bigdata-Tests umfassen spezielle Tools und Frameworks mit klaren Schritten zum Erstellen, Speichern, Abrufen und Analysieren von Daten in bemerkenswerter Größe, d.h. mit großem Volumen, hoher Geschwindigkeit und großer Vielfalt.

Die Schritte müssen strategisch geplant werden, um die richtigen Merkmale der Daten zu verstehen.

Die 5 wichtigsten Merkmale sind;

- Velocity (Geschwindigkeit des Ablaufs und der Verarbeitung)

- Volume (Größe)

- Variety (Formate)

- Veracity (Genauigkeit)

- Value (Wert und Nutzen)

Was sind Data Processing-Strategien?

Da es sich um eine strategische Aufgabe handelt, ist es notwendig, die Strategie zu planen. Die Strategie entscheidet über die Vorgehensweise bei der Verarbeitung und ist daher mit dem Thema Data Processing verknüpft. Data Processing kann auf 3 Arten erfolgen;

- Batch,

- in Echtzeit und

- iterativ.

Die Aufgabe des Big Data Processing wird von Dateningenieuren erledigt, und Big Data Testing wird von QA-Ingenieuren durchgeführt. Für die Prüfung der Data Quality sind DQM-Tools (Data Quality Management) sehr hilfreich.

Viele Aspekte von Big Data müssen getestet werden. Diese Gebiete bilden ganze Testkategorien für sich allein. Zum Beispiel Funktionstests, Leistungstests, Datenbanktests und Infrastrukturtests. E-Commerce ist ebenfalls ein Bereich, in dem Big Data eine große Rolle spielt. E-Commerce-Websites wie Alibaba, Amazon, Wish und Flipcart haben einen enormen Datenverkehr und können pro Minute eine riesige Menge an Daten und sensorischen Eingaben erzeugen.

Was sind die üblichen Big Data Testing-Strategien?

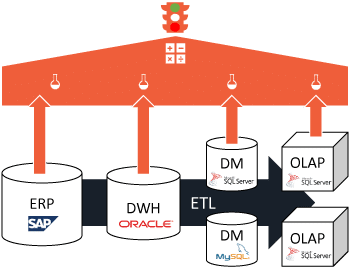

Wir erörtern vier Hauptteststrategien: Data Ingestion Tests, Data Processing Tests, Data Storage Tests und Data Migration Tests.

1. Data Ingestion Tests sind Tests mit mehreren Datenquellen wie Dateien, Protokollen, Sensoren und Uploads. Bei diesen Tests geht es vor allem darum, zu überprüfen, ob das Laden und Extrahieren der Daten vollständig ist oder nicht. Die Daten müssen entsprechend dem Schema ohne Beschädigung/Verlust eingelesen werden. Hierzu werden Teile der Daten entnommen und die Ergebnisse verglichen.

2. Data Processing Testing sind die Tests von zusammengefassten Daten. Dabei wird sichergestellt, dass die Geschäftslogik intakt ist und die Eingaben und Ausgaben übereinstimmen. Weitere Informationen finden Sie im obigen Abschnitt "Was sind Data Processing-Strategien?".

3. Data Storage Tests sind die Überprüfung der Ausgabe und des korrekten Ladens in das Data Warehouse.

4. Data Migration Tests sind die Tests, die durchgeführt werden, nachdem die Anwendung von einem Server auf einen anderen verschoben wurde. Das kann aufgrund von organisatorischen Anforderungen, technologischen Änderungen oder Anweisungen der Geschäftsleitung geschehen. Das neue und das alte System werden verglichen und gegenübergestellt.

Man unterscheidet drei Haupttypen von Migrationstests: vor der Migration, während der Migration und nach der Migration. Alle Konfigurationen werden ebenfalls getestet und die Funktionalitäten werden verglichen.

Was sind die wichtigsten Aktivitäten bei Datenbank-Tests?

Für ein erfolgreiches Datenbank-Testing gibt es drei Hauptaktivitäten. Alle haben eines gemeinsam: Sie sind alle Validierungsprozesse.

1. Validierung # 1 - Datenbereitstellung: Validierung der Eingabedaten.

2. Validierung # 2 - Prozess-Validierung: Validierung der verarbeiteten Daten.

3. Validierung # 3 - Validierung der Ausgabe: Validierung der im Data Warehouse gespeicherten Daten.

Welche Vorgehensweise gibt es bei Leistungstests für Big Data-Anwendungen?

Für den Laien sind Big-Data-Projekte solche, bei denen große Datenmengen schnell verarbeitet werden. Das erfordert Rechenleistung und einen reibungslosen Datenfluss. Jedes Big Data-Tool muss so konzipiert sein, dass ein fehlerfreier Betrieb möglich ist. Deshalb sind Leistungstests so wichtig.

Wichtige Aspekte der Leistungstests beziehen sich auf die Speicherauslastung, die Reaktionszeiten und die Verfügbarkeit der Anwendung. Die Leistung sollte bei der Entwicklung und Nutzung von Big Data-basierten Anwendungen Priorität haben. Jobs und Standardverfahren nutzen Routinen und testen sie später, um Big Data sinnvoll und überschaubar zu nutzen.

Welche Art von Funktionstests gibt es bei Big Data-Anwendungen?

Für einen Laien bedeutet funktionales Testen das Testen des Frontends anhand des Anforderungsdokuments. Der Schwerpunkt der Funktionstests liegt auf dem Vergleich der Ergebnisse der Anwendung und der Validierung der Daten. Ähnlich wie beim funktionalen Testen normaler Softwareanwendungen verhält es sich beim Testen von Big Data-Anwendungen.

Do the first step! Get in touch with BiG EVAL...

BLOG